■臺灣師範大學機電工程學系 / 柯坤呈 助理教授

前言

今年來,因應製程自動化與智慧化之趨勢,影像辨識已廣泛應用於諸多產線,透過合適影像辨識下,提供使用人員提升製程友善操作也更能對周遭環境做出更合理、更智慧的判斷與反應。

工業4.0[1]中,機器視覺[2]佔據了關鍵環節,透過視覺影像設備取得大量圖像數據資料,並利用人工智慧[3,4]訓練下辨識物件,有利於製程快速檢測和標記有缺陷的商品,達到自動化之應用。近年來,YOLO(You Only Look Once)演算法已廣泛應用於多領域目標的檢測下並致優質成效,其中,YOLO v.4是一種即時、高精度的目標檢測模型,其平均準確率 (Average precision, AP)及影像幀率(Frame per second, FPS)皆優於其他ASFF、Efficient Det、Center Mask等檢測模型。

本文主要提供YOLO v.4演算法應用於射出成型圖像辨識判斷成效,以建立資料庫與YOLO v.4模型,實現高辨識度、高準確度之視覺辨識目的。

實驗架構與研究方法

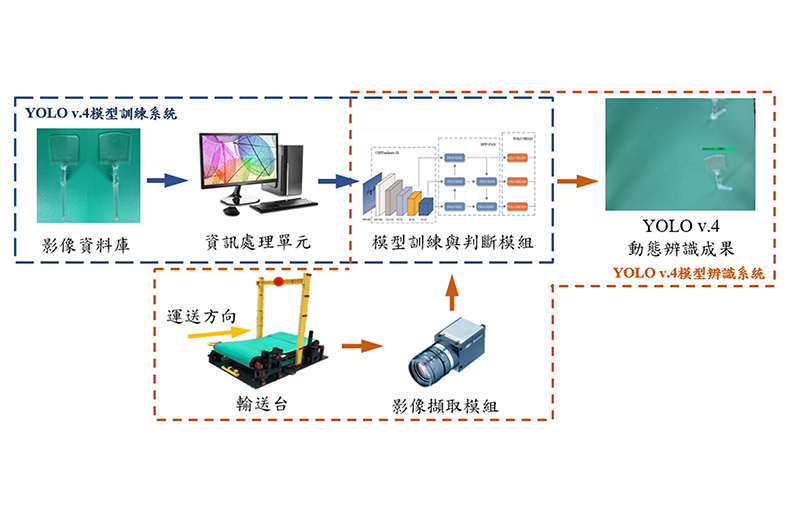

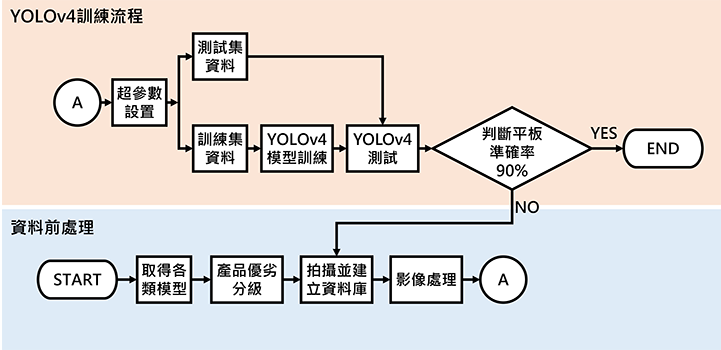

本文首先以田口實驗設計法設置超參數,並利用S/N因子比分析,比較不同控制因子在同一實驗中對視覺辨識結果產生的影響。最後透過所得到的最佳解數據匯入YOLO v.4中進行訓練,並配合已搭建完成之輸送臺進行即時辨識,圖1為實驗流程架構,將依序進行說明:

- 資料庫建立:取得完整及瑕疵之射出件並將其良劣分類。拍攝高度距物件固定為高度40公分,以確保成像品質均一,再利用影像擷取系統拍攝完整及瑕疵射出件圖片各五百張。

- 資料前處理:針對圖形進行特徵區域標記,汰除不必要之資訊干擾,強化特定區域之學習成效。

- 超參數設置:以田口實驗法四因子三水準之L9直交表設置超參數。

- YOLO v.4訓練及測試:導入設置之超參數、物件標籤、訓練集和測試集圖片後進行權重之訓練。訓練完畢再導入訓練權重及測試圖片進行辨識。

- 透過辨識結果數據進行田口實驗之S/N比分析,分析各因子之最佳水準,並驗證最佳超參數組合。

- 輸送臺搭建並結合先前訓練完畢YOLO v.4模型,進行即時辨識。

本文設置四個控制因子分別為Ignore_thresh(閾值)、Learning Rate(學習率)、Batch(組數)及IoU_loss。透過調整其數值並找到每一超參數之區域最佳解。實驗共進行了三次searching,前兩次透過田口實驗法L9直交表進行訓練找出最佳化超參數組合,第三次則是以驗證最佳解為目的,調整單一因子 Ignore_thresh(閾值)之數值,求得本文之超參數最佳組合。

為使數據結果更加穩定,本文於前兩次searching皆將完整之L9直交表訓練五次,取其平均進行S/N比分析,而後透過擷取控制因子水準之S/N比加總平均,求得之最大值為最佳參數組合。

實驗結果

最佳化超參數搜索

First searching中,利用田口實驗法L9直交表訓練權重,以權重測試圖片得到十個part的之平均預測值,並計算標準差與S/N比,即可針對S/N比進行因子反應分析。驗證各因子之最佳解Ignore_thresh(閾值)為0.1;Learning Rate(學習率)為10-3;Batch(組數)為128;IoU_loss為giou,並驗證First searching之最佳解,如圖1。

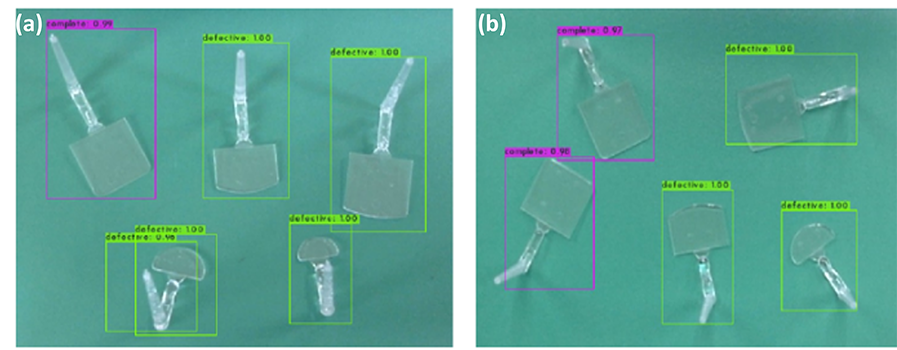

為確認調動閾值是否會影響其他三因子之最佳解,在Second searching中將閾值範圍縮小,水準分別調整為0.3、0.5及0.7,其餘因子之水準皆不變,實驗後計算預測值之S/N比,進行因子反應分析及繪製因子反應分析表。求得各因子之最佳解分別為Ignore_thresh(閾值)為0.3;Learning Rate(學習率)為10-3;Batch(組數)為128;IoU_loss為giou。結果顯示當改變Ignore_thresh(閾值)之數值範圍時,不會影響到其餘三個控制因子的最佳組合,並驗證Second searching於測試圖(a)與(b)之最佳辨識結果,如圖2。

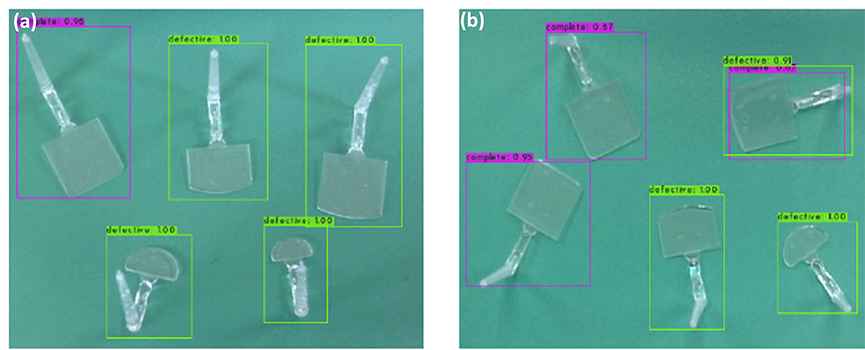

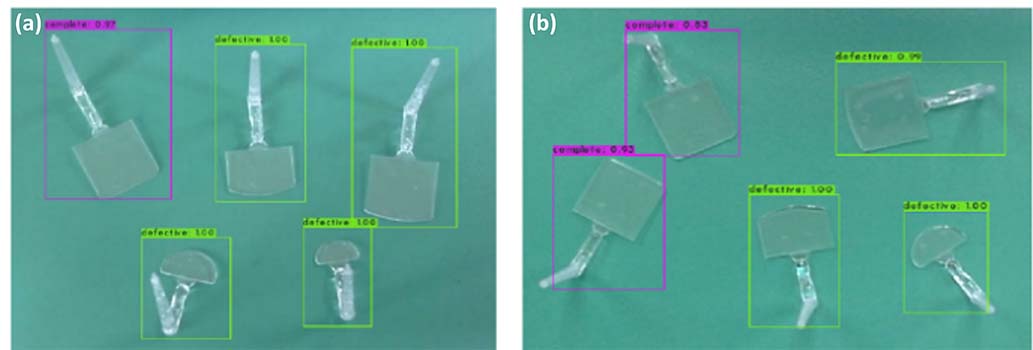

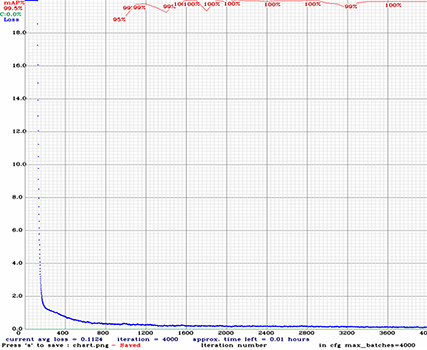

儘管First searching和Second searching之預測結果正確,但容易產生多重預測框的情形,因此在 Third searching中則是透過調整閾值之大小,尋求閾值最佳解。從閾值為0.1依次調整閾值到0.9,觀察預測結果,產生多重預測框時,取預測最低值紀錄,並計算其S/N比。由S/N比分析結果可知,當Ignore_thresh為0.5時有最大S/N比,代表當Ignore_thresh為0.5可以達到最佳之辨識結果,並且解決了多重預測框之問題,如圖3,在Third searching最佳解之訓練報告圖表當中,也看到mAP值達99.5%,loss值也降到0.1124,達到了預期的成果,如圖4。

最佳化超參數測試與結果

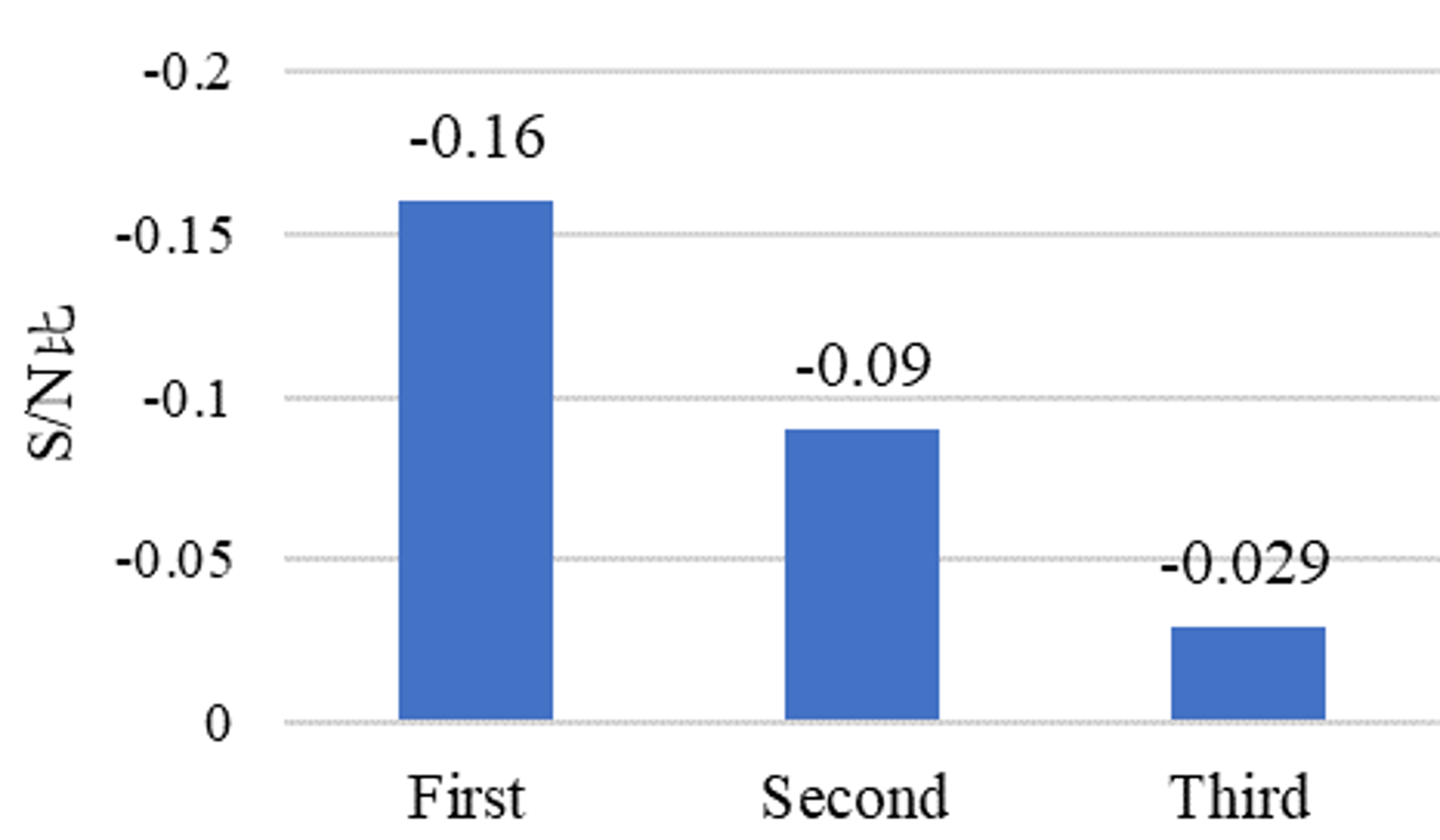

透過三次searching之數據結果進行S/N比計算與分析,First searching之最佳解Ignore_thresh為0.1,Second searching為0.3,Third searching則為0.5。Third searching之S/N比相較First searching之S/N比進步了0.13,相較Second searching則是進步了0.06。

由此結果可顯示,Third searching最佳解參數組合之S/N比雖然較前兩次searching最佳解參數組合之S/N比有小幅度之提升,但代表參數之優化已到達穩定的狀態(圖5),Third searching了解到Ignore_thresh主要是對預測框靈敏度之影響,數值設置過低容易產生多重預測框,容易產生預測錯誤或重複預測之情形。最後以Third searching求得之最佳超參數組合為本文優化成功之訓練模型,解決了多重預測框之問題,也達到良好之預測結果,即Ignore_thresh(閾值)為0.5;Learning Rate(學習率)為10-3;Batch(組數)為128;IoU_loss為giou為本實驗之最佳參數組合。

Third searching所得最佳化超參數組合之訓練模型進行測試。將影像擷取模組設置在設計之輸送臺的上方40公分處,驅動輸送臺並將射出件隨機放之輸送帶上,連續紀錄數個預測準確值,為即時辨識預測結果,由數據表可得即時辨識之準確率為94%。由模型預測結果得知,以YOLO v.4 模型辨識射出件之成品優劣可行且有效。

結論

本文透過田口實驗法L9直交表進行參數設置應用於辨別射出件成品優劣之 YOLO v.4 模型,透過S/N比分析參數變動對於辨識準確度的影響,透過模型預測結果得知,以YOLO v.4模型辨識射出件之成品優劣可行且有效,未來可以增加射出件之種類、增加資料庫數量,以提升即時辨識之準確率。本文結果總結如下:

- 透過First searching找到超參數最佳解組合與其中一實驗數據同為表現優異之模型。

- 透過Second searching找到較First searching優之參數最佳解組合,並發現Ignore_thresh(閾值)之改變不會影響其他控制因子之最佳解。

- Third searching求出最佳解Ignore_thresh(閾值)為5,解決測試中出現多個預測框的問題。

- 本文透過實驗找出影響辨識準確率之控制因子,並求得辨識射出件之最佳參數組合,即Ignore_thresh(閾值)為5;Learning Rate(學習率)為10-3;Batch(組數)為128;IoU_loss為giou之參數組合。

- 將求得之最佳參數組合之YOLO v.4模型配合輸送臺進行即時辨識,且辨識準確率高達94%。

本文由柯坤呈 助理教授、黃家祐、王敏軒、邱家琪共同編撰完成。

參考文獻

[1] M. Javaid, A. Haleem, R.P. Singh, S. Rab, R. Suman, Exploring impact and features of machine vision for progressive industry 4.0 culture, Sensors International. 3 (2022) 100132.

[2] H. Nhat-Duc, Q.-L. Nguyen, V.-D. Tran, Automatic recognition of asphalt pavement cracks using metaheuristic optimized edge detection algorithms and convolution neural network, Automation in Construction. 94 (2018) 203–213.

[3] K.K. Ramachandran, A. Apsara Saleth Mary, S. Hawladar, D. Asokk, B. Bhaskar, J.R. Pitroda, Machine learning and role of artificial intelligence in optimizing work performance and employee behavior, Materials Today: Proceedings. (2021).

[4] R.S.K. Boddu, P. Karmakar, A. Bhaumik, V.K. Nassa, Vandana, S. Bhattacharya, Analyzing the impact of machine learning and artificial intelligence and its effect on management of lung cancer detection in covid-19 pandemic, Materials Today: Proceedings. (2021).